A classe média urbana, antes considerada a espinha dorsal de economias estáveis, enfrenta uma crise sem precedentes desde o século XVIII. E, desta vez, a ameaça não vem de senhores feudais ou monarcas, mas de algoritmos e do capital concentrado.

Uma crise existencial para a classe média urbana, que no século XVIII correspondia à burguesia ou às classes de comércio, torna a situação, se não resolvida, um possível análogo moderno da crise que desencadeou a Revolução Francesa. Em vez da opressão feudal, ela é impulsionada pelo deslocamento tecnológico e pela concentração de capital, ambos reforçados por ciclos de retroalimentação.

Uma Perspectiva Histórica

Para compreender os riscos, temos que olhar para trás. Na França pré-revolucionária, a burguesia era educada, economicamente ativa e socialmente ambiciosa. Eram comerciantes, artesãos e profissionais que criavam valor, pagavam impostos e, ainda assim, tinham influência política limitada. Frustrada por hierarquias rígidas, desigualdade sistêmica e injustiça estrutural, essa classe se tornou a faísca da Revolução Francesa.

A classe média urbana de hoje ocupa um papel semelhante na sociedade. Inclui profissionais qualificados, trabalhadores de tecnologia, educadores e pequenos empresários. São produtivos, instruídos e essenciais para a economia, mas cada vez mais pressionados por forças fora de seu controle. Nesse sentido, os paralelos com a burguesia do século XVIII são impressionantes: uma classe vital para o sistema, mas vulnerável a pressões estruturais, capaz de provocar mudanças sociais e políticas se levada ao limite.

Fatores Modernos

Ao contrário da opressão feudal antiga, a ameaça existencial atual vem de duas forças interligadas: deslocamento tecnológico e concentração de capital.

O deslocamento tecnológico está remodelando os mercados de trabalho enquanto escrevo este post. Sistemas de IA e automação não se limitam mais a tarefas manuais rotineiras; estão avançando sobre serviços profissionais, desenvolvimento de software, finanças, educação e até trabalhos criativos. Funções antes consideradas seguras estão sendo automatizadas em um ritmo sem precedentes. O resultado é uma lacuna crescente entre habilidades que a tecnologia pode replicar e aquelas que permanecem exclusivamente humanas e valiosas.

A concentração de capital amplifica o problema. Os ganhos de produtividade impulsionados pela IA fluem desproporcionalmente para quem possui ou pode arrendar a tecnologia e a infraestrutura – grandes corporações, conglomerados de tecnologia e investidores ricos. Enquanto isso, o crescimento salarial para a força de trabalho em geral congela. À medida que o capital se centraliza, a classe média vê seu poder de compra, mobilidade e segurança cada vez mais restritos.

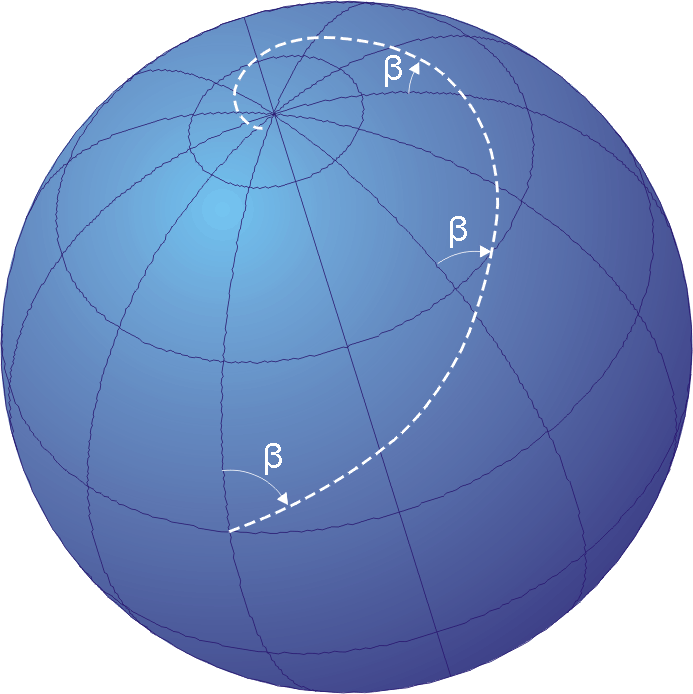

Ciclos de retroalimentação tornam a situação ainda mais precária. Trabalhadores deslocados gastam menos, reduzindo a demanda do consumidor. As empresas respondem cortando custos ainda mais e investindo mais em automação, o que desloca mais trabalhadores. A produtividade aumenta, os lucros corporativos disparam e a desigualdade acelera, reforçando a crise subjacente.

Consequências Além da Economia

As implicações desta crise vão além de salários e cargos. Economicamente, a estagnação salarial e a erosão dos empregos tradicionais da classe média ameaçam a acessibilidade à moradia, a segurança na aposentadoria e a sustentabilidade das dívidas. A classe média pode ter à frente uma escada de mobilidade social ascendente cada vez menor, deixando a próxima geração com menos oportunidades que a anterior.

Socialmente, a pressão pode ser profunda. A história mostra que a percepção generalizada de injustiça pode gerar agitação.

A classe média urbana é educada e politicamente consciente, uma combinação que a torna sensível às disparidades e injustiças sistêmicas. Se a frustração crescer sem controle, o resultado pode ser uma reconfiguração significativa das normas sociais e políticas.

Psicologicamente, a crise ameaça identidade e propósito. Durante décadas, profissionais da classe média se definiram por habilidades, conquistas e contribuições. Quando a tecnologia substitui aspectos centrais do trabalho, indivíduos podem enfrentar uma reavaliação existencial de seu papel na sociedade, aprofundando estresse e insatisfação.

Navegando na Crise

O que pode ser feito? Não há solução simples. Políticas como renda básica universal, redistribuição de riqueza direcionada ou democratização da propriedade de IA podem ajudar a mitigar o deslocamento. Programas de requalificação e educação podem preencher lacunas de habilidades, mas esses esforços frequentemente ficam aquém do necessário para competir com a adoção tecnológica em larga escala.

O verdadeiro desafio é sistêmico. Ciclos de retroalimentação operam mais rápido que os mecanismos tradicionais de políticas públicas. Sem medidas proativas para abordar a concentração de renda e a disrupção tecnológica, as pressões sociais e econômicas podem se acumular mais rapidamente do que governos ou instituições conseguem reagir.

Um Chamado à Consciência

A crise iminente da classe média não é inevitável, mas ignorar as pressões estruturais arrisca um colapso social que a história já mostrou poder ser rápido e dramático. Compreender as forças em jogo, aprender com analogias históricas e desenhar intervenções políticas com visão de futuro são passos essenciais para evitar instabilidade generalizada.

A classe média urbana está em uma encruzilhada. Como a burguesia do século XVIII, possui ferramentas para perceber e desafiar desigualdades. Mas, ao contrário de então, os desafios são tecnológicos, não feudais. A questão é se a sociedade reconhecerá os sinais de alerta antes que a crise atinja um ponto crítico, ou se os ciclos de retroalimentação de deslocamento e concentração de capital conduzirão à próxima grande convulsão.