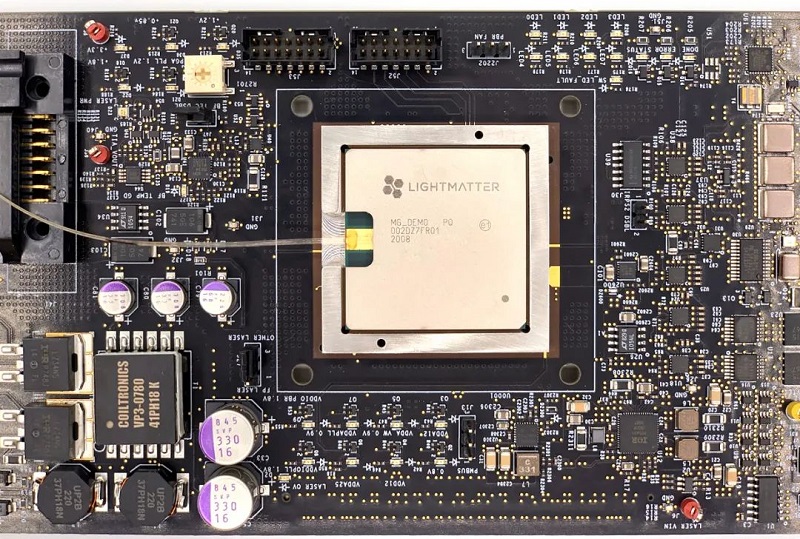

Para concluir a Rápida Introdução à ‘Inteligência Artificial’, publico o post complementar, para apresentar o inovador chip ótico [ainda sem nome comercial] da start-up Lightmatter, contendo o chamado interferômetro Mach-Zehnderque, que promete elevar a computação de sistemas de aprendizagem de máquinas a um novo patamar.

O aprendizado de máquina profundo, ou seja, redes neurais artificiais com muitas camadas ocultas, sempre nos fascina com soluções inovadoras para problemas do mundo real, cada vez em mais áreas, incluindo processamento de linguagem natural, detecção de fraude, reconhecimento de imagem e direção autônoma. As redes neurais ficam melhores a cada dia.

Mas esses avanços têm um preço enorme nos recursos de computação e no consumo de energia. Portanto, não é de se admirar que engenheiros e cientistas da computação estejam fazendo grandes esforços para descobrir maneiras de treinar e operar redes neurais profundas com mais eficiência.

Uma nova e ambiciosa estratégia que está fazendo o ‘début’ este ano é executar a computação de redes neurais usando fótons em vez de elétrons. A Lightmatter começará a comercializar no final deste ano seu chip acelerador de rede neural que calcula com luz. Será um refinamento do protótipo do chip Mars que a empresa exibiu em agosto passado.

Embora o desenvolvimento de um acelerador ótico comercial para aprendizado profundo seja uma conquista notável, a ideia geral de ‘computação com luz’ não é nova. Os engenheiros empregavam regularmente essa tática nas décadas de 1960 e 1970, quando os computadores digitais eletrônicos ainda não tinham capacidade para realizar cálculos complexos. Assim, os dados eram processados no domínio analógico, usando luz.

Em virtude dos ganhos da Lei de Moore na eletrônica digital, a computação óptica nunca realmente pegou, apesar da ascensão da luz [fibras óticas] como veículo para comunicação de dados. Mas tudo isso pode estar prestes a mudar: a Lei de Moore, que durante décadas proporcionou aumentos exponenciais na capacidade dos chips eletrônicos, mostra sinais de estar chegando ao fim, ao mesmo tempo em que as demandas da computação de aprendizado profundo estão explodindo.

Não há muitas escolhas para lidar com esse problema. Pesquisadores de aprendizagem profunda podem até desenvolver algoritmos mais eficientes, mas é difícil prever se esses ganhos serão suficientes. Essa é a razão da Lightmatter estar empenhada em “desenvolver uma nova tecnologia de computação que não dependa do transistor”.

Fundamentos

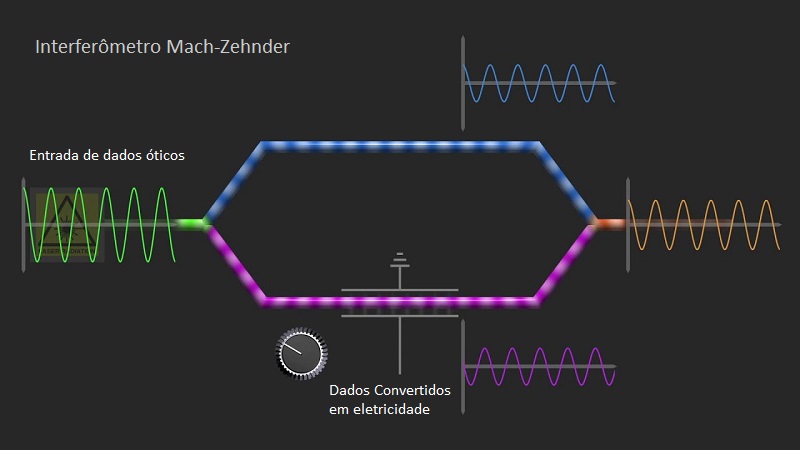

O componente fundamental no chip Lightmatter é um interferômetro Mach-Zehnder. Esse dispositivo ótico foi inventado em conjunto por Ludwig Mach e Ludwig Zehnder na década de 1890. Mas só recentemente esses dispositivos óticos foram miniaturizados a ponto de um grande número deles poder ser integrado em um chip e usado para realizar as multiplicações de matrizes envolvidas nos cálculos de rede neural.

Esses feitos só se tornaram possíveis nos últimos anos devido ao amadurecimento do ecossistema de manufatura de fotônica integrada, necessário para fazer chips fotônicos para comunicações.

O processamento de sinais analógicos transportados pela luz reduz os custos de energia e aumenta a velocidade dos cálculos, mas a precisão pode não corresponder ao que é possível no domínio digital. O sistema é 8-bits-equivalente. Isso por enquanto mantém o chip restrito a cálculos de inferência de rede neural – aqueles que são realizados depois que a rede foi treinada.

Os desenvolvedores do sistema esperam que sua tecnologia possa um dia ser aplicada também ao treinamento de redes neurais. O treinamento exige mais precisão do que o processador ótico pode fornecer nesta etapa.

A Lightmatter não está sozinha em busca da luz para cálculos de redes neurais. Outras startups que trabalham nesta linha são Fathom Computing, LightIntelligence, LightOn, Luminous e Optalysis.

A Luminous espera desenvolver sistemas práticos em algum momento entre 2022 e 2025. Portanto, ainda teremos que esperar alguns anos para ver como essa abordagem vai evoluir. Mas muitos estão entusiasmados com as perspectivas, incluindo Bill Gates, um dos maiores investidores da empresa.

Uma coisa é clara: os recursos de computação dedicados aos sistemas de inteligência artificial não podem continuar a crescer sustentavelmente na taxa atual, dobrando a cada três ou quatro meses. Os engenheiros estão ansiosos para utilizar a fotônica integrada para enfrentar esse desafio de construir uma nova classe de máquinas de computação drasticamente diferentes daquelas baseadas nos chips eletrônicos convencionais, que agora se tornam viáveis para fabricação. São dispositivos que no passado recente só podiam ser imaginados.