Vivemos a falar sobre algoritmos e sobre a influência que exercem sobre a sociedade. Mas algoritmos têm pouco a ver com a assim-chamada ‘revolução da IA’ e participam apenas da fase de input dos dados que serão processados pelas camadas ocultas das redes neurais subjacentes. O resultado dessa computação emerge naturalmente dos dados de uma forma fascinante.

Neste post exploro sucintamente o que diferencia esses modelos de IA do software tradicional.

O Software Tradicional: algoritmos e Controle Total

O software tradicional, como as aplicações que usamos para navegar na web ou para organizar nossas tarefas diárias, é criado a partir de uma programação clara e controlada pelos desenvolvedores. Nesse tipo de software, os desenvolvedores são responsáveis por decidir como ele deve funcionar. Eles estruturam a arquitetura do software, definem as entradas e saídas, criam os fluxos de dados e, essencialmente, escrevem as regras que governam o funcionamento do programa. A lógica do código é escrita manualmente, com pouca ou nenhuma intervenção de dados externos.

Por exemplo, quando um desenvolvedor cria um sistema de gerenciamento de tarefas, ele pode definir exatamente como os dados devem ser exibidos na interface do usuário, como as informações serão organizadas em um banco de dados e quais ações o usuário pode executar. O comportamento do software é, portanto, determinado por uma série de decisões conscientes tomadas pelos desenvolvedores, com base em sua experiência e nas necessidades do usuário.

O Software de Aprendizado de Máquina: Os Dados “Programam” o Comportamento

Por outro lado, quando falamos de software de aprendizado de máquina, como os LLMs, o cenário muda drasticamente. Esses modelos não são programados da mesma forma que o software tradicional. Eles são, de certa forma, “treinados” em grandes volumes de dados, e seu comportamento é amplamente determinado pelas características e padrões presentes nesses dados.

A diferença principal está no fato de que, enquanto no software tradicional o desenvolvedor controla diretamente o comportamento do sistema, nos modelos de aprendizado de máquina o desempenho do modelo é ditado pelos dados que ele recebe. O desenvolvedor pode escolher o tipo de modelo (por exemplo, redes neurais profundas ou florestas aleatórias) e o algoritmo a ser utilizado, mas a maneira como o modelo responde aos dados e, por consequência, como ele se comporta em diferentes cenários, é algo que emerge de forma dinâmica e não totalmente previsível.

Quando treinamos um modelo como um LLM, por exemplo, ele aprende a identificar padrões de linguagem, relacionamentos entre palavras e estruturas de frases a partir de enormes quantidades de textos. O modelo, então, ajusta seus parâmetros internos (algo que pode ser descrito como uma “programação automática”) para se tornar cada vez mais eficaz em prever ou gerar linguagem com base no que aprendeu. A inteligência do modelo é resultado direto da interação com os dados, e o papel do desenvolvedor é criar a infraestrutura que permita esse aprendizado, mais do que codificar explicitamente cada comportamento ou resultado.

A Emergência de Comportamentos Complexos

O mais fascinante sobre os LLMs é que seu comportamento não pode ser totalmente previsto ou controlado, mesmo por seus criadores. Eles “aprendem” de forma autônoma, ou seja, a partir dos dados com os quais são alimentados. Isso cria um software mais flexível, capaz de lidar com uma variedade de situações de forma adaptativa. No entanto, também significa que o controle direto sobre o comportamento do sistema não é tão claro quanto em um software tradicional.

Por exemplo, ao treinar um modelo de linguagem, um desenvolvedor pode não conseguir prever exatamente como o modelo irá responder a uma pergunta específica, porque sua resposta é uma combinação complexa de dados anteriores, padrões de linguagem e o contexto em que a pergunta foi feita. Isso é muito diferente de um software tradicional, onde o desenvolvedor pode prever e controlar precisamente o comportamento do programa em todas as situações.

A Nova Era do Software

Portanto, os LLMs e outros modelos de aprendizado de máquina nos mostram que a programação de software não é mais uma tarefa totalmente controlada pelo ser humano através de um algoritmo. Em vez disso, esses modelos demonstram uma nova forma de processamento de dados que é, em grande parte, determinada pela interação com dados reais. O papel do desenvolvedor é mais sobre criar as condições para que o aprendizado aconteça, do que programar diretamente cada aspecto do comportamento do software.

Isso nos leva a uma reflexão importante: à medida que avançamos para o futuro da tecnologia, as linhas entre o que é “programado” e o que é “aprendido” estão se tornando cada vez mais tênues. O software está se tornando mais inteligente, mas também mais imprevisível, e essa é uma das características mais emocionantes da inteligência artificial.

Leituras adicionais:

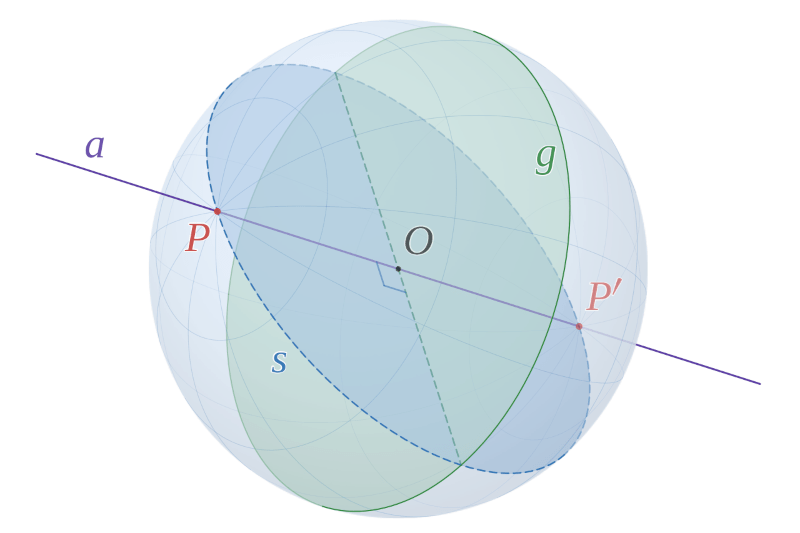

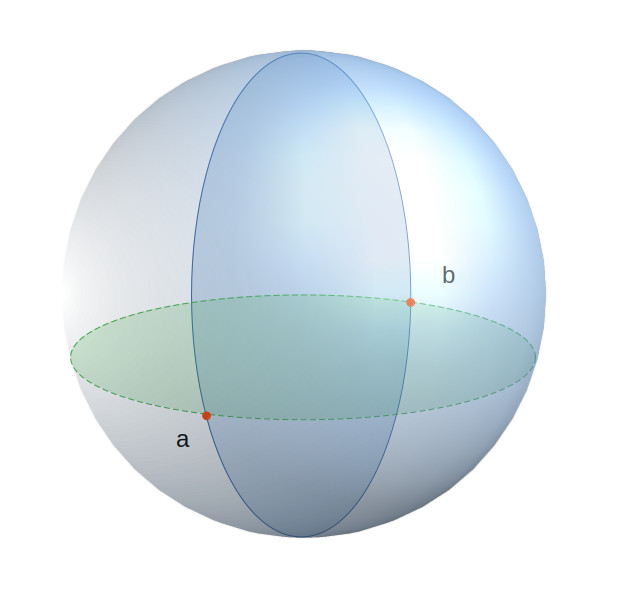

Algoritmo:

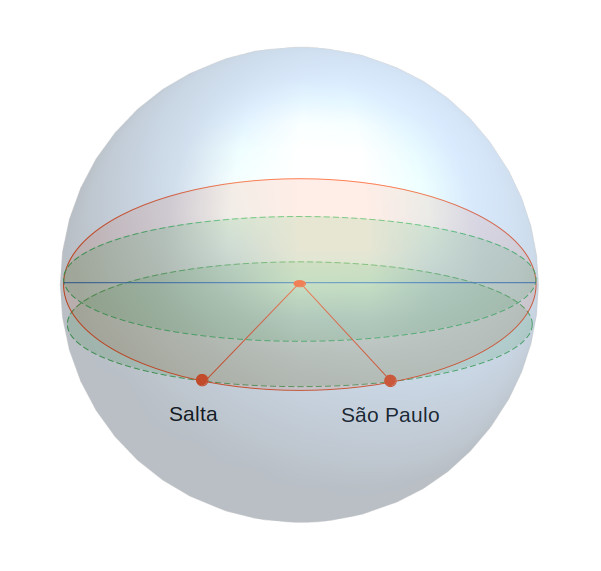

Comportamento Emergente: