Faço uma resenha crítica de um artigo muito pertinente publicado no MIT Press Reader , de autoria dos psicólogos Amos Tversky e Daniel Kahneman. O trabalho trata de dois grandes grupos de problemas e suas e implicações e correlações com o pensamento humano e com a inteligência de máquina.

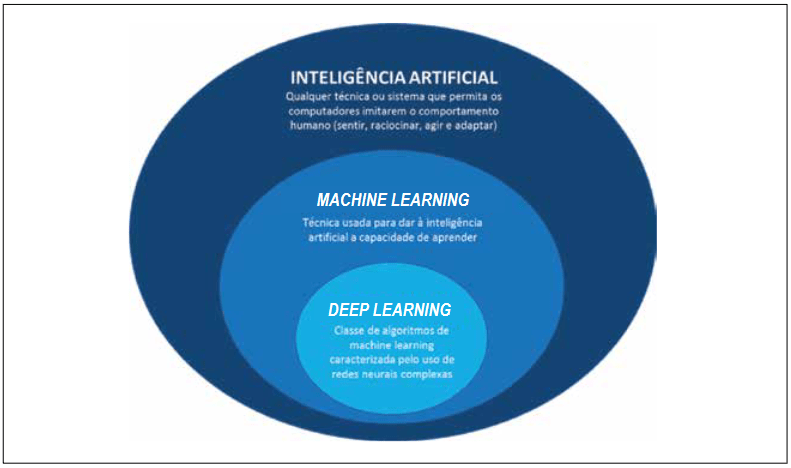

A ênfase das abordagens computacionais da inteligência que nos acostumamos a ver no noticiário tem sido colocada em problemas formais e bem estruturados; problemas que têm um objetivo claro e um número definido de soluções possíveis. Esses problemas são os que podem ser, portanto, resolvidos por um algoritmo.

Mas nós, humanos, somos criativos, irracionais e inconsistentes. Concentrar-se nesses problemas bem estruturados às vezes pode ser enganoso e improdutivo – como o proverbial bêbado a procurar as chaves perdidas ao redor do poste, só porque ali é onde a luz brilha mais forte.

Os autores argumentam que existem dois grupos de problemas que são muito típicos da inteligência humana e merecem um olhar atento.

Um grupo contém os chamados problemas de insight. Os problemas de insight geralmente não podem ser resolvidos por um procedimento passo a passo, como um algoritmo, ou, quando podem, o processo se torna extremamente tedioso. Em vez disso, os problemas de insight exigem a reestruturação da própria abordagem do solucionador do problema.

Outro grupo são os problemas de procedimento [no artigo original é usada a expressão “problems of path” – problemas de caminho]. Em problemas de procedimento o solucionador tem disponível uma representação, que inclui um estado inicial, um estado objetivo e um conjunto de ferramentas ou operadores que podem ser aplicados para percorrer a representação. Em problemas de insight o solucionador não tem essas balizas.

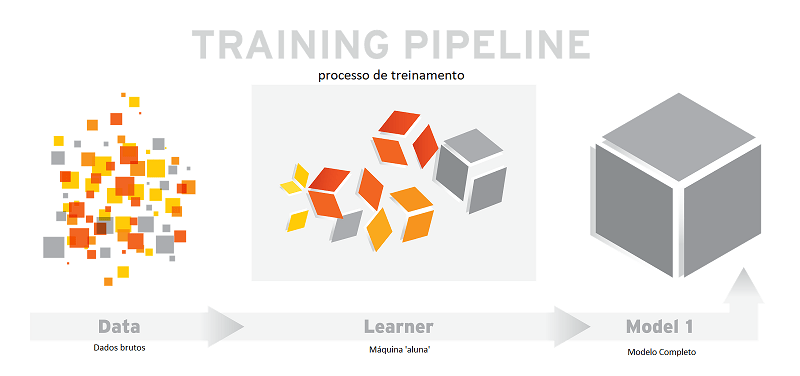

Com problemas de procedimanto o solucionador geralmente pode avaliar quão próximo o estado atual do sistema está do estado objetivo. A maioria dos algoritmos de aprendizado de máquina depende desse tipo de avaliação.

Com problemas de insight, por outro lado, muitas vezes é difícil determinar se houve algum progresso até que o problema seja essencialmente resolvido. O que chamaríamos “efeito eureka” ou “momento aha!”, uma compreensão repentina de uma solução anteriormente incompreensível.

Insights são para humanos

De acordo com os autores, os problemas de insight podem ser representados de diversas maneiras. A maneira como você pensa sobre um problema, ou seja, como você representa o problema, pode ser fundamental para resolvê-lo.

Muito pouco se sabe sobre como resolvemos problemas de insight. Esses problemas são normalmente difíceis de estudar em laboratório com muita profundidade, porque as pessoas tễm uma dificuldade natural em descrever as etapas que percorrem para resolvê-los. A maior parte desses problemas pode ser resolvida com a obtenção de um ou dois insights secundários capazes de mudar a natureza do enfoque sobre eles.

Todos nós sabemos que as pessoas nem sempre se comportam da maneira estritamente sistemática necessária para o pensamento rigorosamente lógico. Esses desvios não são falhas ou erros no pensamento humano, mas características essenciais sem as quais provavelmente a inteligência não evoluiria.

Normalmente não parecemos prestar muita atenção às partes formais de um problema – especialmente quando fazemos escolhas arriscadas. Tversky e Kahneman descobriram que as pessoas fazem escolhas diferentes quando apresentadas às mesmas alternativas, dependendo de como essas alternativas sejam descritas.

Em alguns dos testes realizados, as pessoas preferiam o resultado certo ao incerto, quando o certo era enquadrado num tom positivo, e preferiam a alternativa incerta à certa, quando a certa era enquadrada num tom negativo. Com efeito, a estrutura ou tom das alternativas modulou a disposição dos participantes em aceitar o risco.

Nossas decisões, sejam elas corretas ou incorretas, sempre são produzidas pelos mesmos processos cognitivos. Ao contrário dos computadores, somos relativamente limitados no que podemos manter na memória ativa ao mesmo tempo.

Processos rápidos, processos lentos

Temos uma complexidade no nosso pensamento e processos intelectuais que nem sempre trabalha a nosso favor. Tiramos conclusões precipitadas. Somos mais facilmente persuadidos pelos argumentos que se adequam às nossas visões preconcebidas, ou que são apresentados num contexto ou noutro. Às vezes nos comportamos como computadores, mas na maioria das vezes somos desleixados e inconsistentes.

Daniel Kahneman descreve a mente humana como consistindo de dois sistemas, um que é rápido, relativamente impreciso e automático, e um outro que é lento, deliberado, e demora para chegar a uma conclusão mas, quando finalmente chega, é consistentemente mais preciso.

O primeiro sistema, diz ele, é ativado quando você vê a imagem de uma pessoa e percebe que ela está com raiva e provavelmente gritará. O segundo sistema é acionado quando você tenta resolver um problema de multiplicação como 17 × 32. O reconhecimento da raiva, em essência, surge em nossa mente sem nenhum esforço óbvio, mas o problema de matemática requer esforço deliberado e talvez a ajuda de lápis e papel (ou uma calculadora).

O que ele chama de segundo sistema está muito próximo do estado atual da inteligência artificial. Envolve esforços deliberados e sistemáticos que exigem o uso de invenções cognitivas.

O desenvolvimento dos sitemas computacionais inteligentes concentrou-se no tipo de trabalho realizado pelo sistema deliberado, embora o sistema automático ativado pelo reflexo possa ser tão ou mais importante. E pode ser mais desafiador de emular em um computador.

Mais fatos interessantes [em inglês] seguindo o link:

https://thereader.mitpress.mit.edu/ai-insight-problems-quirks-human-intelligence/